Introduction

Pour certains : Cloud = réduction des coûts IT, alors que cela n’est pas forcément vraie !

Quand on adopte le Cloud, c’est surtout pour bénéficier de la puissance d’un CloudOs : puissance de calcul, Sclabilité, Fléxbilité …

Plusieurs clients déployant des Workloads dans le Cloud ou migrant celles hébergées initialement OnPrem, se rendent compte que les factures à la fin du mois peuvent vite devenir salées car souvent oublient de définir une gouvernance Azure « Financière » qui leur permettent de contrôler, comment les ressources Cloud sont déployées, consommées et monitorées.

J’ai décidé aujourd’hui de partager avec vous quelques Best Practices ainsi que des « Tips & Tricks » vous permettant de contrôler et d’optimiser votre conso Azure.

Plus précisément, nous allons parler des items suivants :

- Azure Advisor

- Les Reserved Instances

- Azure Hybrid Benefit

- Arrêts/Démarrages auto des VMs Azure

- Utilisation des Stratégies (Policies) Azure

- Utilisation des Tags

- Utilisation du Stockage Azure de type « Cool & Archive »

- Utilisation d’Azure Budgets

- Utilisation de l’Auto-Scaling

- Dimensionnement des ressources Azure

- Utilisation des Souscriptions Azure Dev/Test

- CleanUp des ressources Azure

Bonne lecture à tous :).

#1 : Azure Advisor

Azure Advisor est un Consultant Azure « Virtuel » et « Automatisé » qui vous aide à optimiser et sécuriser vos déploiements Cloud mais aussi à réduire vos coûts Azure. Il s’appuie sur tout un ensemble de « Best Practices » et règles de conformité/sécurité standards.

En effet, Azure Advisor examine la configuration de tous vos services Azure déployés et vous propose des recommandations dans les domaines suivants

- Haute Disponibilité

- Sécurité

- Performance

- Coût

Le périmètre d’analyse Azure Advisor est limité aux :

- Abonnements

- Groupes de Ressources

Vous pouvez utiliser Azure Advisor pour analyser/évaluer la configuration de vos ressources, Az Advisor pourra ensuite vous proposer des recommandations en cas de sous-utilisation de certaines Workload tels que les VM Azure.

Dans l’exemple suivant, Azure Advisor nous fait part de deux recommandations assez intéressantes :

- Downsizer plusieurs VM Azure car celles-ci sont sous-utilisées, cela nous fera apparemment économiser +2200€ /an

- Supprimer une Adresse/Interface IP Public qui n’est apparemment, associée à aucune ressource Azure, cela nous fera +30€ d’économie.

Azure Advisor : Pricing

Azure Advisor est un service gratuit :).

A noter tout de même que vous avez la possibilité de souscrire à un panel d’options de support (AzAdvisor) à partir de 24€.

eBook Azure Advisor : j’ai récemment publié sur BecomeITExpert.com un eBook dédié à Azure Advisor, Cliquez ici pour en savoir plus.

#2 : Azure Reserved Instances

Azure Reserved Instances (Azure RI) vous permettent de réduire considérablement votre consommation Azure (jusqu’à 72%) en vous engagement sur 1 ou 3 ans.

Le principe est simple : plus on s’engage dans le temps pour consommer, plus on obtient de remise.

En fonction de la durée d’engagement (1 ou 3 ans), vous pouvez obtenir des remises pouvant atteindre les -72%.

Tip : vous pouvez atteindre 80% de remise si vous activez l’Azure Hybrid Benefit‘. Voir section suivante pour en savoir plus.

Services concernés par Azure RI

Les réservations concerne uniquement le Compute (Puissance de calcul). Les RI peuvent être achetées pour les services Azure suivants :

- Azure VM

- Azure Cosmos DB

- Azure SQL Database

- Azure SQL Data Warehouse

- App Service

Note importante : les réduction de coût Azure via les RI concerne uniquement la puissance de calcul (Compute). Le coût relatif au stockage, réseau, licences (eg : Azure SQL) ne sont pas concernées les instances réservées.

Pré-requis

Pour pouvoir acheter des instances réservées, vous devez avoir le rôle « Owner /Propriétaire » au niveau de l’abonnement.

Qui peut acheter des Instances réservées ?

Pour pouvoir acheter des instances réservées, vous devez avoir le rôle « Owner /Propriétaire » au niveau Souscription de type :

- [EA] Enterprise Agreement (Offres : MS-AZR-0017P ou MS-AZR-0148P)

- Pay-As-You-Go (Offres : MS-AZR-0003P ou MS-AZR-0023P)

- Microsoft Customer Agreement.

Si vous êtes CSP (Cloud Solution Provider), vous pouvez utiliser soit le Portail Azure ou le Centre Partenaire pour acheter des Réservation Azure..

Modalités de paiement

Vous pouvez payer une réservation à l’avance ou tous les mois. Une même réservation avec paiement initial et avec paiements mensuels a le même coût total : vous ne payez pas de frais supplémentaires si vous optez pour le paiement mensuel.

- Note : Le paiement mensuel est disponible pour les réservations Azure, et non pour les produits tiers.

1 ou 3 ans ? combien puis-je économiser exactement ?

Seul la Calculatrice Azure peut répondre à ce type de question :).

Voyons combien nous coûtera une VM Windows « Standard_B4ms » réservée pendant 3 ans, et hébergée en France (Central).

- Rendez-vous sur Calculatrice Azure, et ajoutez « Machine Virtuelle« .

- Configurez les options suivantes :

- Région : France Central

- Guest OS : Windows

- Niveau : Standard

- SKU : B4ms

Pour du Pay-as-you-Go (sans engagement), cette VM nous coûtera 163,52$ /mois

Calculons maintenant le prix de cette même VM avec un engagement sur 3 ans (Réservation pendant 3 ans)

Comme indiqué dans la capture d’écran ci-dessus, nous économisons ~100$ /mois avec un RI de 3 ans : 3600$ sur les 3 ans, ce qui n’est pas négligeable du tout.

Acheter des Reserved Instance

Cliquez ici pour acheter des instances réservées Azure.

Ce Blade vous permet également de visualiser les RI déjà achetées !

Dans l’exemple suivant, nous allons acheter une instance réservée de VM, commencez par cliquer sur « Acheter maintenant »

Cliquez sur « Acheter » sous « Machine Virtuelle » :

Le Menu suivant apparaît, vous pouvez définir des filtres (eg : dureé d’engagement 1an ou 3 an, région Azure…) :

Il suffit de sélectionner la VM qui vous intéresse pour la réserver pendant 1 ou 3 ans, vous pourrons ainsi réduire votre conso Compute Azure.

Pour en savoir plus sur les instance Réservées Azure, je vous invite à consulter cette page.

Information utile

Les réservations peuvent être annulées à tout moment, vous switcherez automatiquement en mode Pay-as-you-Go dès annulation d’une réservation.

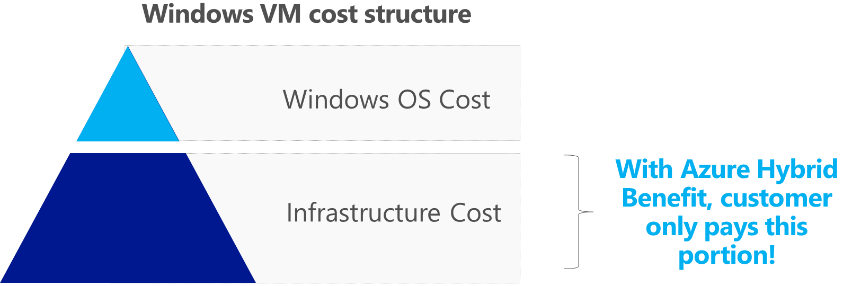

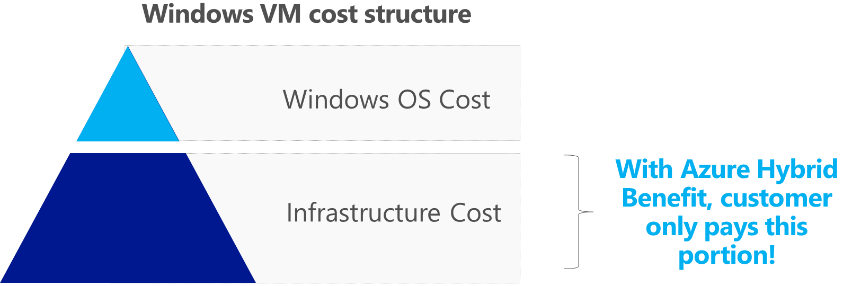

#3 : Azure Hybrid Benefit

Azure Hybrid Benefit est une option tarifaire qui vous permet d’étendre vos Licences Windows Server et SQL Server dans le Cloud Azure.

Si vous disposez des licences Windows Server ou SQL Server via contrat SA (Software Assurance) ou équivalent (Licences de type EAS, Abonnement SCE ou Abonnement Open Value), sachez que vous pouvez les réutiliser pour vos Workloads Azure (Azure VM, Azure SQL, ou SQL Server sur des VMs Azure), et réduire le coût de ces ressources de manière considérable.

Vous économisez généralement jusqu’à 80% quand vous combinez Azure Hybrid Benefit avec les instances réservées (RI) Azure.

Source : Microsoft Docs

Services concernés par Azure Hybrid Benefit

La liste des services/produits est la suivante :

- Windows Server Standard Edition avec Software Assurance

- Windows Server Datacenter Edition avec Software Assurance

- SQL Server Enterprise Core avec Software Assurance

- Azure SQL Database

HowTo : activer Azure Hybrid Benefit

Azure Hybrid Benefit peut être activé lors du déploiement d’une nouvelle VM, vous pouvez également l’activer sur des VMs existantes.

Il suffit de répondre « Oui » au niveau de l’option « Vous disposez déjà d’une licence Windows Server » lors du déploiement d’une nouvelle VM Azure.

Vous devez ensuite confirmer cela en cochant « Je confirme que j’ai une licence Windows Server avec Software Assurance… » :

Si vous avez oublié de le faire pour vos anciens déploiement VMs, vous pouvez toujours activer l’Azure Hybrid Benefit au niveau du Blade « Configuration » de vos VMs, voir exemple suivant :

Il s’agit ici d’une méthode manuelle, qui n’est bien évidemment pas la plus adaptée quand il s’agit d’un environnement Azure avec plusieurs dizaines ou centaines de VMs. Cela peut être réalisé de manière automatisée via des scripts PowerShell (Update-AzVM) ou Az CLI (az vm update).

Tip : les commandes PS et Az CLI qui vous permettent d’updater la configuration de vos VMs pour activer Azure Hybrid Benefit sont listées ci-dessous :

Commandes PowerShell

$vm = Get-AzVM -ResourceGroup "saisir_ici_leNom_de_votre_RG"

$vm.LicenseType = "Windows_Server"

Update-AzVM -ResourceGroupName "saisir_ici_leNom_de_votre_RG" -VM $vm

Commande Az CLI (2.0)

az vm update --resource-group "saisir_ici_leNom_de_votre_RG" --set licenseType=Windows_Server

Forcez l’utilisation d’Azure Hybrid Benefit

Perso, pour mes clients disposant déjà d’un contrat SA, je déploie plutôt une Policy Azure qui exige l’activation d’Azure Hybrid Benefit pour tout nouveau déploiement de VM, cela permet de s’assurer que toute VM déployée est configurée avec Hybrid Benefit.

Le code JSON de la Policy est le suivant :

{

"type": "Microsoft.Authorization/policyDefinitions",

"name": "enforce-hybrid-use-benefit",

"properties": {

"displayName": "Enforce hybrid use benefit",

"description": "This policy will enforce usage of hybrid use benefit.",

"parameters": {},

"policyRule": {

"if": {

"allOf": [

{

"field": "type",

"in": [

"Microsoft.Compute/virtualMachines",

"Microsoft.Compute/VirtualMachineScaleSets"

]

},

{

"field": "Microsoft.Compute/imagePublisher",

"equals": "MicrosoftWindowsServer"

},

{

"field": "Microsoft.Compute/imageOffer",

"equals": "WindowsServer"

},

{

"field": "Microsoft.Compute/imageSKU",

"in": [

"2008-R2-SP1",

"2008-R2-SP1-smalldisk",

"2012-Datacenter",

"2012-Datacenter-smalldisk",

"2012-R2-Datacenter",

"2012-R2-Datacenter-smalldisk",

"2016-Datacenter",

"2016-Datacenter-Server-Core",

"2016-Datacenter-Server-Core-smalldisk",

"2016-Datacenter-smalldisk",

"2016-Datacenter-with-Containers",

"2016-Datacenter-with-RDSH"

]

},

{

"field": "Microsoft.Compute/licenseType",

"notEquals": "Windows_Server"

}

]

},

"then": {

"effect": "deny"

}

}

}

}

Après implémentation de cette Policy, si l’équipe Ops Azure tentent de déployer une nouvelle VM sans activation de l’Azure Hybrid Benefit, elle recevra le message d’erreur suivant :

Combien puis-je économiser avec Azure Hybrid Benefit ?

Microsoft propose un outil (Web) qui vous permet de calculer combine vous pourrez économiser avec l’activation de l’Azure Hybrid Benefit, l’outil est disponible depuis cet URL.

Dans l’exemple suivant, nous faisons un calcul simple sur la base de 100 Licences Windows Server (Datancer) qui seront activées dans Azure via l’offre Hybrid Benefit. Pour bénéfier de l’offre Hybrid Benefit, les VMs Azure sur lesquelles vos Licences SA seront activées doivent respecter certaines SKU, dans l’exemple suivant, la VM SKU D3 v2 est sélectionnée :

Comme montré dans la capture d’écran, grâce à Azure Hybrid Benefit, nous économisons presque 25.000€ /an pour 100 Licences Windows Server.

Cela dû au fait qu’avec Azure Hybrid Benefit, vous économiserez le coût de la Licence Windows Server (Standard ou Datacenter) et vous payerez uniquement les frais liés à l’infrastructure Azure hébergeant votre VM :

Consultez cette page pour en savoir sur Azure Hybrid Benefit

#4 : Configurer des arrêts/démarrages auto sur vos VMs

Planifier des arrêts et démarrages automatiques sur vos VMs Azure non critiques/hors production: Dev, Recette, Intégration, Sandbox…

Cela vous permet de réduire vos coûts Azure de manière considérable (jusqu’à 66%).

Prenons l’exemple d’une VM à 100$/mois qui est utilisée uniquement 7 ou 8 heures par jour, si vous planifiez son arrêt/démarrage automatique, vous serez facturés uniquement pendant les 7/8 heures d’exécution, vous paierez donc 100$ /3 = 33,33$ au lieu de 100$.

Options d’arrêt/démarrage auto

Il existe plusieurs options/fonctionnalités vous permettant de planifier des arrêts/démarrage auto de vos VMs.

- Fonctionnalité Buit-in appelée « Arrêt automatique« , disponible au niveau de chaque VM

-

- Notez que cette feature ne vous permet pas le démarrage automatique de la VM, cela devra donc se faire à la main ou via un scheduler/script.

- Utilisation d’Azure Automation : je vous invite à consulter cette page pour en savoir plus

- Note : un post dédié à ce sujet est en cours de finalisation, n’hésitez pas à vous abonner sur mon Blog pour être informé dès sa publication.

#5 : Définir et Appliquer des Stratégies (Policies) Azure

Azure Policy une composante critique et importante du modèle de gouvernance global Azure.

Les Stratégies Azure vous permettent de définir vos standards de sécurité/conformité, et s’assurer que les ressources déployée sont « Compliant » depuis le déploiement jusqu’à exécution/utilisation.

Azure Policy peut être utilisé pour contrôler le type de SKU pouvant être déployé dans vos environnements Azure.

Le use-case qui revient le plus, est l’utilisation d’Azure Policy pour forcer l’utilisation de certains SKU de VM Azure (SKU Whitelisting) pour éviter l’utilisation de certains « SKU Monster » comme la M Serie (Up to 128 vCPUs /3.8TB de RAM) pouvant générer une consommation Azure très importante.

Dans l’exemple suivant, nous allons utiliser Azure Policy pour autoriser que les Azure VM SKU suivants :

D Serie, plus précisément :

Pour ce faire, sélectionnez votre abonnement (ou un RG si vous souhaitez appliquer cette Stratégie au niveau d’un RG), cliquez sur « Stratégies« , cliquez ensuite sur « Assigner une stratégie« , l’assistant s’affiche et vous demande de renseigner certains valeurs de paramètres.

Cliquez sur … au niveau de la définition de la stratégie, et cherchez la définition SKU, comme montré dans la capture d’écran suivante :

Sélectionnez « Références SKU de machine virtuelle autorisées« , attribuez un nom à votre Policy Assignment, et cliquez sur Suivant pour continuer.

Sélectionnez les SKU de VM à autoriser (onglet « Paramètres« ), dans l’exemple suivant, nous allons sélectionner les 3 SKU suivants : D1_v2, D2_v2 et D3_v2

Enfin, cliquez sur « Vérifier + Créer » pour assigner votre Policy. Celle-ci apparaît désormais sous « Affectations » :

Comme montré dans la capture d’écran suivant, un Admin Azure tente de créer une VM en SKU G, le déploiement est refusé par la Policy que nous venons de définir, pour pouvoir déployer une VM Azure dans notre environnement, le SKU doit correspondre à D1_v2, D2_v2 ou D3_v2, Vous pouvez ainsi contrôler les coûts Azure générés par vos ressources IaaS Azure VM.

Guide pas à pas sur « Azure Policy »

Si vous voulez en savoir plus sur Azure Policy, je vous invite à consulter le guide pas à pas suivant :

Il s’agit d’un Slideshare, vous pouvez le consulter/télécharger directement depuis ce Link.

#6 : Forcer l’utilisation des Tags

Les Tags vous permettent d’organiser vos Ressources Azure de manière logique et par Catégorie.

L’utilisation de Tags dans Azure est primordial, car vous permettra de savoir :

- Qui est propriétaire de la ressource (Tag : ResourceOwner)

- La ressource appartient à quelle application (Tag : Application Name)

- S’agit d’une ressource Dev/PreProd/Prod [Tag : EnvironmentType) ?

- La ressource a été déployée pour quel besoin (Tag : Project Code)

- Qui contacter en cas de maintenance de la ressource, si la machine doit être Patchée et rebooté (Tag : TechnicalContact)

- A qui doit-on (re)facturer cette ressource la fin du mois ? si la notion du charge-Back est adoptée (Tag : CostCenter)

- …

Grâce aux Tags Azure, vous pouvez faire un regroupement des coûts (par Appli, par type d’environnement …), ces informations sont très précieuses aux yeux du DAF :).

Les Tags vous permettent de connaitre combien vous coûtent vos ressources Dev à un instant T. Quel est le ResourceOwner qui consomme le plus de Ressources Azure …

Vous aurez compris, Tagger les ressources Azure devient plus qu’une bonne pratique, mais un moyen efficace pour suivre et tracer qui, consomme, quoi dans vos environnements Azure.

Si vous voulez en savoir plus sur Azure Tags, je vous invite à consulter le guide pas à pas suivant :

Il s’agit d’un Slideshare, vous pouvez le consulter/télécharger directement depuis ce Link.

#7 : Configurer des niveaux d’accès de type « Cool & Archive »

Toutes les données que vous uploadez vers ou générez depuis Azure ne doivent pas nécessairement être stockées sur du stockage Haute Performance. si vous classifiez vos données et créez des catégories avec le niveau de performance exigé, vous allez vite vous rendre compte que plusieurs types de données ne nécessitent pas vraiment un type de stockage très performant.

Azure propose aujourd’hui différents niveaux d’accès au Blog Stockage : Hot, Cool et Archive.

Le niveau d’accès « Hot » est surement dédié aux données qui sont fréquemment utilisées.

Les deux autres Access Tiers (Cool & Archive) peuvent être configurée quand il s’agit des données rarement utilisées (fichiers de Backup, logs…)

Pour économiser le coût lié au Stockage Azure, il est est recommandé d’utiliser les niveaux d’accès Cool & Archive et de n’utiliser le niveau « Hot » que quand c’est nécessaire.

Pourquoi utiliser un stockage Cool & Archive plutôt que Hot ?

Voyons d’abord c’est quoi la différence entre les niveaux « Cool » et « Archive ».

Stockage Azure « Cool »

Le niveau de stockage de type « Cool », concerne les données peu consultées qui doivent être stockées (archivées) pendant au moins 30 jours. Quelques scénarios typiques incluent la sauvegarde des données avant archivage (sur des systèmes d’archivage), des fichiers multimédias, des logs/fichiers d’audit ou encore des données utilisés pour de l’Analytics Big Data…

Stockage Azure « Archive »

Comme son nom l’indique, le niveau de stockage de type « Archive » est un stockage peu coûteux pour les données d’archivage qui seront rarement consultées/accédées. Ce niveau concerne les données qui resteront stockées (archiveées) pendant au moins 180 jours, comme par exemple les données de sauvegarde l’historique médical, les fichiers logs, enregistrements audios/tél…

Quels avantages ?

Le coût d’un compte de Stockage configuré avec les niveaux d’accès « Cool » ou « Archive » sont beaucoup moins cher que celui en niveau d’accès « Hot ».

Consultez le tableau ci-dessous pour en savoir plus

Note importante : l’Archive Storage reste le moins coûteux > le 1 GB est à 0,002$ seulement (pour les 50 premiers TB).

Vous pouvez consulter le document ci-dessous pour en savoir plus sur les niveaux d’accès à Azure Storage

https://docs.microsoft.com/fr-fr/azure/storage/blobs/storage-blob-storage-tiers

#8 : Pensez à configurer des alertes quand le Budget est dépassé

Azure fournit aujourd’hui plusieurs outils de gestion des coûts Azure, tels que « Analyse de coût », « Alertes de coût » ou encore « Azure Budgets« .

Ces outils vous permettent d’analyser, évaluer et suivre votre consommation Azure en temps réel.

Nous allons nous intéresser à Azure Budget dans un premier temps.

Grace à Azure Budget, vous pouvez définir votre budget pour une Application, Groupe de ressource, un abonnement …

Azure Budget vous permet également de suivre la consommation de ce budget mais aussi et surtout être alerté en cas de dépassement.

Note importante : en cas de dépassement des seuils budgétaires définis, seules des notifications sont déclenchées (alerte par mail). Aucune de vos ressources n’est impactée ou arrêtée et votre consommation n’est pas arrêtée. Azure Budget est simplement utilisé pour définir un Quota, comparer et suivre les dépenses lors de l’analyse des coûts.

Dans l’exemple suivant, nous définissons un budget de 1000€ /mois pour un groupe de ressource dédiée à une Application métier appelée « HRApp » :

Les alertes (par Mail) suivantes sont positionnées/définies :

Enfin, vous pouvez suivre/monitorer la consommation du budget défini depuis la Blade « Budgets » de votre RG ou Abonnement (colonne « Progression ») :

Note importante : L’outil Azure Budget est disponible uniquement depuis les abonnements Azure de type EA.

#9 : Auto-Scaling

Un Cloud (Public ou Privé) se caractérise par les notions d’Élasticité et l’auto-Scaling, ce sont aujourd’hui les arguments qui poussent une DSI d’aller vers le Cloud.

L’auto-scaling permet d’étendre ou réduire automatiquement votre environnement Cloud. Vous n’avez plus à intervenir pour déployer des VMs supplémentaires ou supprimer ceux dont vous n’avez plus besoin,

Si vous disposez d’un site web e-Commerce hébergé dans le Cloud, vous pouvez mettre en place des mécanismes d’auto-scaling pour étendre ou réduire les capacités de votre web site en fonction de la charge (nombre de visiteurs/visites..). Si des Pics d’activité se présentent, votre web site sera re-sizer automatiquement pour supporter cette montée en charge, et sera downsizer quand l’activité revient à la normale.

Scalabilité horizontale vs scalabilité verticale

Il existe deux types de Scaling : Horizontale et Verticale

Scaling Verticale

Le Scaling Verticale est le plus intuitif : cela revient à ajouter des ressources à une VM unique (en lui ajoutant de la RAM, en changeant son CPU pour un plus véloce…). C’est simple ! Mais :

- Le coût est rapidement exponentiel de la capacité matérielle.

- Cette solution a des limites : vous pourrez probablement multiplier par 2 les capacités de votre serveur, peut-être même par 5, mais pas par 100 !

Cela reste dans la majorité des cas la solution la plus pragmatique, et en particulier pour des applicatifs en production depuis de nombreuses années.

Scaling Horizontale

Le Scaling horizontale revient à ajouter de nouveaux serveurs réalisant le même type tâche. Cela permet de n’utiliser que des serveurs standards (on parle de commodity hardware). Mais les implications logicielles sont rapidement importantes !

- L’application doit être stateless (sans état) : cela signifie que les données sont stockées dans un autre service (dans votre base de données, dans un cache distribué…)

C’est l’idéal. Vous devriez concevoir vos nouveaux développement avec cet objectif.

- Si votre applicatif stocke des données en local (par exemple des données de sessions utilisateurs stockée en RAM) : vous pouvez malgré tout scaler horizontalement s’il est possible de couper ces données en sous ensembles indépendants (on parle de sharding). Il est alors nécessaire de s’assurer que chaque client ne communique qu’avec un unique serveur. Cela passe par exemple par un proxy qui redirige le client vers un serveur applicatif donné en fonction des identifiants du client, on parle de sticky session.

- Si il n’est pas possible de sharder facilement vos données, alors vous ne pouvez pas scaler horizontalement sans modifier en profondeur votre applicatif. Vous devez, au moins temporairement, vous en tenir à un scaling vertical.

Options d’auto-scaling Azure

Azure propose plusieurs options d’auto-Scaling vous permettant d’auto-configurer les capacités de vos services Cloud, le but étant de payer uniquement les ressources/capacités dont vous avez besoin, uniquement lorsque vous en avez besoin et éviter de payer des ressources/capacités inutiles.

Il est recommandé de concevoir et mettre en place une stratégie d’auto-Scaling sur vos ressources de Production Azure.

Je vous invite à consulter le post ci-dessous pour en savoir plus sur les options d’auto-Scaling Azure :

https://docs.microsoft.com/fr-fr/azure/azure-monitor/platform/autoscale-overview

#10 : Azure Dev/Test Subscriptions ?

Si vous êtes abonnés « Visual Studio », que vous souhaitez Builder des environnements Azure de Dev & Test, il est recommandé de souscrire à l’offre Azure Dev/Test plutôt qu’un abonnement Azure standard.

Azure Dev/Test, qu’est-ce que c’est ?

Azure Dev/Test est une offre Azure dédiée aux Développeurs (exclusivement aux individus et sociétés disposant d’un abonnement Visual Studio) ayant besoin d’environnement Sandbox pour concevoir, développer et tester des services & applications dans Azure.

Avec l’offre Azure Dev/Test, trois options sont disponibles :

Ce qu’il faut retenir :

- Offre « Particulier » : Si vous êtes un Freelance/Particulier et souhaitez avoir un environnement de Dev/Test sur Azure, cette offre est faite pour vous. Votre abonnement VS (Visual Studio) vous permettra d’avoir jusqu’à 130€ de crédit azure mensuel. C’est à vous de décider comment vous utilisez votre crédit mensuel. Il existe plusieurs services Azure auxquels vous pouvez attribuer le crédit (cf liens ci-dissous). Les Software inclus dans votre abonnement Visual Studio peuvent être utilisé sur les VMs Azure sans frais supplémentaires. De plus, vous payez un tarif réduit pour les VMs Azure.

Si vous dépassez le crédit inclut (130€ Max), vous serez facturés de manière mensuelle (dès réception de la facture). Pour finir, notez qu’un seul abonnement Azure Dev/Test (par abonnement VS) est autorisé

- Offre « Equipes » (Clients EA : Enterprise Agreement) : vous permet d’avoir plusieurs abonnements Azure Dev/Test pour vos différentes équipes de Dev. Vous n’avez pas besoin de saisir les infos de votre CB lors de la souscription à l’offre Azure Dev/Test, vous serez facturés dans le cadre de votre contrat EA. Contrairement à l’offre « Particulier », cette option vous offre la possibilité de donner la main à vos End users pour exécuter les tests (recette) et donner leurs feedbacks.

- Offre « Equipes » (Hors Clients EA) : si vous êtes abonnés VS mais ne disposez pas de contrat EA et souhaitez avoir des abonnements Azure Dev/Test, eh bien dans rentrez dans cette catégorie. La différence avec l’option précédente réside dans le fait que vous êtes facturés de manière mensuelle (par CB et à réception de la facture).

Quels avantages ?

Tout d’abord, il faut noter que les trois options listées précédemment vous permettent d’utiliser les Software inclus dans votre abonnement Visual Studio (environnements de Dev & Test uniquement) sans frais supplémentaires. Pour l’exécution de VMs Azure, vous bénéficiez d’un prix réduit basé sur le prix de VM Linux.

Reportez-vous au tableau ci-dessous pour en savoir plus sur les avantages/remises possibles avec l’offre Azure Dev/Test :

Créer votre abonnement Azure Dev/Test

L’option ajouter un nouvel abonnement vous redirige vers le Portail suivant, il suffit de sélectionner ‘Abonnement Dev/Test » et suivre l’assistant pour créer votre nouvel abonnement Azure Dev/Test :

Quelques liens utiles

Je vous invite à consulter les documents suivants pour en savoir plus sur l’offre Azure Dev/Test « Particulier », « Equipes /EA » et « Equipes /Hors EA » :

Si vous souhaitez donc déployer des Workloads (de Dev/Test) dans Azure, privilégiez l’utilisation d’Azure Dev/Test :).

#11 : Downsizer les ressources oversizées

Une autre bonne pratique consiste à auditer/analyser régulièrement (une fois /mois par exemple) les ressources Azure pour identifier d’éventuelles ressources sur-dimensionner. Vous pouvez ensuite procéder à une Downsizing de ces services/ressources pour réduire les coûts Azure associés.

Ces opérations peuvent être industrialisées/automatisées à l’aide d’options/features d’auto-scaling (Up & Down) fournis avec Azure (cf Section #9).

#12 : Pensez à faire le CleanUp

Planifiez des CleanUp régulièrement !

Si cela ne se fait pas de manière automatique (via des RunBooks + Tags « EndDate /Date_Suppression… »), je vous propose la méthode /process suivant :

- Auditer /Identifier toutes les ressources « Inactives » : WebApps, VMs … éteintes et ne présentant aucune activitée depuis plus de 3 mois

- Se référer aux Tags pour connaitre les Resources Owner (Propriétaire) de ces ressources

- Rentrer en contact avec ces personnes pour leur faire part de vos futures opérations (suppression des ressources)

- Obtenir un GO /Validation des responsables/Owner de ces ressources

- Planifier la suppression des ressources non utilisées.

- Reporter (un mail suffit) après la réalisation des actions de suppression.

On a tous connu des Devs ou Business Users qui ont déployés pleins de RG à des fins de tests, mais qui n’ont jamais pris le temps d’arreter ou supprimer ces ressources en fin de PoC/Sandbox.

Ce Process vous permet de faire le ménage de manière régulière pour économiser les frais associés aux ressources déployées mais aussi avoir une infrastructure Azure propre et Always UpToDate :).

What Else ?

Partagez ces 12 BP avec votre DAF, il va surement Liker le post :).

A bientôt, Stay tuned.

#HK